Nossa realidade está ficando mais falsa: como a investigação forense pode detectar deepfakes?

- Adriano Miranda

- 28 de mar. de 2025

- 6 min de leitura

Artigo de DuckDuckGoose e Foclar.com

Deepfakes são imagens ou vídeos falsos hiper-realistas, gerados ou manipulados por inteligência artificial (IA), nos quais pessoas (in)existentes parecem fazer e dizer coisas que nunca fizeram. O University College London [1] classificou os deepfakes como a ameaça de crime de IA mais séria. Juntamente com a acessibilidade cada vez maior da tecnologia deepfake e a velocidade das plataformas de internet, deepfakes convincentes podem atingir rapidamente milhões de pessoas e ter um impacto devastador em nossa sociedade.

Por quê?

Pense, por exemplo, em entregar evidências falsas ao tribunal, fantoches [2], chantagem, terrorismo ou notícias falsas nas quais figuras políticas confiáveis espalham desinformação, causando perturbação social.

Geração deepfake

Deepfakes se tornaram populares devido à capacidade de fácil utilização de seus aplicativos para uma ampla gama de usuários com ou sem habilidades em informática. Para esse fim, técnicas de aprendizado profundo foram aplicadas representando dados complexos e de alta dimensão.

A primeira instância de geração de deepfake, ou seja, FakeApp, foi desenvolvida por um usuário do Reddit implantando uma estrutura de pareamento autocodificador-decodificador [3]. Este método usa um autocodificador que extrai elementos latentes de imagens faciais e um decodificador que reconstrói as imagens faciais. Para trocar faces de duas imagens alvo, são necessários dois pares codificador-decodificador com o mesmo codificador.

Figura 1: geração de um deepfake usando o par autocodificador-decodificador [4]

Ao implementar a perda adversarial e a perda perceptual na arquitetura codificadora-decodificadora do VGGFace, uma versão aprimorada de deepfakes baseada na rede adversarial generativa (GAN) [5] foi proposta. A perda perceptual do VGGFace melhora a criação de deepfakes de uma forma que os movimentos dos olhos parecem ser mais realistas e consistentes com os rostos de entrada.

Além disso, contribui para suavizar as imagens, resultando em imagens de saída de maior qualidade. Para tornar a detecção e o alinhamento de rostos mais estáveis, a rede neural convolucional multitarefa (CNN) da implementação do FaceNet [6] é introduzida. Os métodos notáveis de geração de deepfakes são resumidos na tabela 1.

Tabela 1: métodos de geração de deepfake amplamente utilizados [7]

Aplicações maliciosas de deepfakes e intervenções governamentais

O primeiro vídeo deepfake surgiu em 2017, no qual o rosto de uma celebridade foi trocado pelo de um ator pornô [7]. Desde então, a tecnologia tem sido usada para influenciar a opinião pública. Um exemplo é a jornalista Rana Ayyub. Seu rosto foi transformado em um vídeo pornográfico como se ela tivesse atuado nele. Este ataque virulento ocorreu logo após ela fazer campanha por justiça para a vítima de estupro de Kathua. Deepfakes também podem servir a incentivos pessoais maliciosos. Uma mãe da Pensilvânia supostamente usou vídeos deepfake explícitos para tentar fazer com que as rivais de torcida de sua filha adolescente fossem expulsas do time [15].

O caso do ministro de assuntos econômicos da Malásia, Azmin Ali, é notável para se analisar. Em 2019, Azmin se envolveu em um escândalo de fita de sexo no qual ele supostamente teve relações sexuais com um membro de seu partido político, Haziq Abdul Aziz [16]. Como a sodomia é um crime na Malásia, que pode levar até 20 anos de prisão [17; 18], Azmin tentou fugir das consequências alegando que o vídeo era um deepfake. Embora ninguém tenha conseguido determinar definitivamente o contrário, a opinião pública e a de especialistas em perícia digital, entre outros, permaneceram divididas [19; 20]. Como o público não consegue distinguir entre quais informações são reais ou falsas, eles estão mais dispostos a adotar seus preconceitos predeterminados [21].

Como resultado, isso teve consequências devastadoras para a reputação e carreira política das partes envolvidas. Além disso, isso levou à desestabilização da coalizão governante e à rejeição enfática dos direitos LGBT na Malásia [22; 18]. De acordo com Towes [21], os deepfakes não apenas deterioram as divisões sociais e interrompem o discurso democrático, mas também prejudicam a segurança pública e enfraquecem o jornalismo.

Portanto, governos e agências de aplicação da lei em todo o mundo estão tomando medidas para prevenir esse problema. Investir em soluções tecnológicas que possam detectar deepfakes e desenvolver legislação apropriada para punir produtores e distribuidores de deepfakes são duas das ações mais propostas pelo governo [20]. De acordo com Welch [23], uma melhor identificação de deepfakes não apenas ajudaria a proteger o direito das pessoas à expressão sem permitir a distribuição de conteúdo prejudicial, mas também ajudaria as plataformas de mídia (social) a melhorar suas políticas sobre deepfakes. Além disso, a legislação apropriada torna ilegal a distribuição de deepfakes com intenção maliciosa e cria recursos para aqueles que foram afetados negativamente por isso [24].

Detecção de deepfake

Mas como o sistema de justiça poderia agir sobre deepfakes realistas e proteger nossa sociedade quando as fronteiras entre imagens digitais reais e falsas estão cada vez mais desaparecendo?

O Mandet 2.0 inclui um filtro de detecção de deepfake que não apenas classifica se uma imagem é deepfake ou real, mas também explica o raciocínio por trás de sua classificação. O principal componente neste filtro de detecção de deepfake, ou seja, DeepFake Detection, é o DeepDetector. O DeepDetector é uma rede neural que tira uma foto de uma pessoa como entrada e analisa o rosto em busca de alterações. Posteriormente, o DeepDetector emite a probabilidade de que um rosto específico tenha sido alterado ou gerado pela tecnologia deepfake.

O DeepDetector foi desenvolvido pela DuckDuckGoose [25] inspirado em avanços recentes no campo da geração e detecção de deepfake [26].

Destacando artefatos deepfake

Existem muitos tipos diferentes de técnicas para gerar deepfakes. Essas técnicas de geração de deepfakes deixam “artefatos” para trás em imagens ou vídeos. Esses artefatos são o resultado de muitos algoritmos de edição ou geração de rostos que exibem artefatos, assemelhando-se a problemas clássicos de visão computacional que decorrem do rastreamento e edição de rostos [27]. Essas imperfeições nos permitem distinguir material real de deepfake. Artefatos deepfake podem incluir características faciais irrealistas ou transições incoerentes entre quadros.

No entanto, as técnicas atuais de geração de deepfake são tão boas que os rostos gerados ou manipulados parecem cada vez mais realistas. Isso resulta em artefatos que são muito difíceis de detectar a olho nu. Um exemplo de tal artefato é a luz refletida nos olhos. O reflexo nos dois olhos em uma imagem de um rosto real será semelhante, pois os olhos estão olhando para a mesma coisa. No entanto, imagens deepfake sintetizadas por GANs falham em capturar com precisão essa semelhança e frequentemente exibem inconsistências. Exemplos disso contêm diferentes formas geométricas ou localizações incompatíveis dos reflexos.

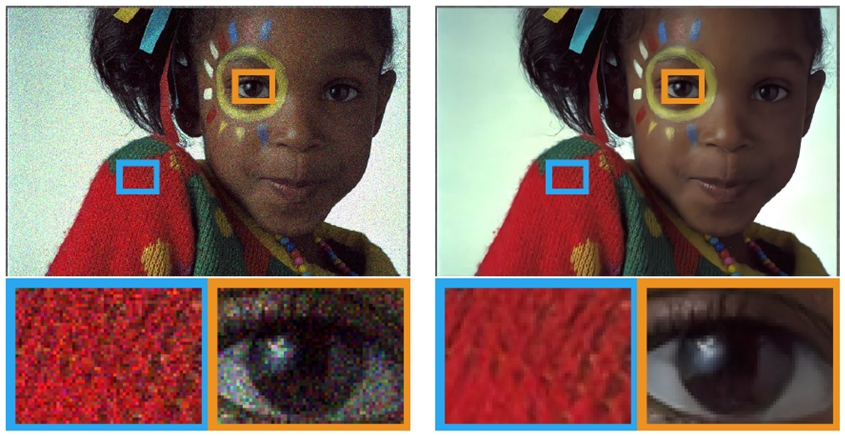

O DeepDetector aproveita o poder das redes neurais artificiais para fazer a distinção entre filmagens reais e deepfakes. Para conseguir isso, o DeepDetector identifica a localização dos artefatos introduzidos pelo deepfake. Isso é feito na forma de um mapa de ativação com base na entrada, dando uma pontuação por pixel permitindo que o usuário do sistema tenha uma ideia de onde o deepfake deixou os artefatos.

Figura 2: destaques gerados pelo filtro DeepFake Detection no Mandet 2.0 para detectar um deepfake

A tecnologia deepfake é uma ameaça emergente à estabilidade governamental. No entanto, há boas notícias; o infocalipse deepfake pode ser mitigado. A tecnologia de IA não é apenas aplicável para criar deepfakes, mas também pode ser usada para reconhecer esses deepfakes. Embora os sistemas de IA sejam conhecidos por funcionar como uma caixa preta, o DeepDetector integrado no Mandet 2.0 gera resultados explicáveis que fornecem insights sobre o raciocínio por trás da classificação binária dessa rede neural para detecção de deepfakes. Dessa forma, os deepfakes podem ser detectados por examinadores forenses, sem ter que depender totalmente de um sistema de IA, mas sim usando sua experiência para antecipar os resultados gerados.

Referências

[1] M. Caldwell, J. T. A. Andrews, T. Tanay, L. D. Griffin. AI-enabled future crime. Crime Science, 2020; 9 (1) DOI: 10.1186/s40163-020-00123-8

[2] Liveness.com - Biometric Liveness Detection Explained. (2021). Liveness.com. https://liveness.com

[3] deepfakes/faceswap. (2021). GitHub. https://github.com/deepfakes/f...

[4] Zucconi, A. (2018, 18 april). Understanding the Technology Behind DeepFakes. https://www.alanzucconi.com/20...

[5] Goodfellow, I. J., Pouget-Abadie, J., Mirza, M., Xu, B., Warde-Farley, D., Ozair, S., Courville, A. & Bengio, Y. (2014). Generative Adversarial Networks.

[6] D. (2018). davidsandberg/facenet. GitHub. https://github.com/davidsandbe...

[7] Thanh Thi Nguyen, Quoc Viet Hung Nguyen, Cuong M. Nguyen, Dung Nguyen, Duc Thanh Nguyen, Saeid Nahavandi. (2021). Deep Learning for Deepfakes Creation and Detection: A Survey. https://arxiv.org/pdf/1909.115...

[8] S. (2018). shaoanlu/faceswap-GAN. GitHub. https://github.com/shaoanlu/fa...

[9] S. (2019). shaoanlu/fewshot-face-translation-GAN. GitHub. https://github.com/shaoanlu/fe...

[10] I. (2021). iperov/DeepFaceLab. GitHub. https://github.com/iperov/Deep...

[11] D. (2020). dfaker/df. GitHub. https://github.com/dfaker/df

[12] S. (2018). StromWine/DeepFake_tf. GitHub. https://github.com/StromWine/D...

[13] Make Your Own Deepfakes [Online App]. (2021). Deepfakes Web. https://deepfakesweb.com

[14] NVlabs. (2019). NVlabs/stylegan. GitHub. https://github.com/NVlabs/styl...

[15] Reporter, G. S. (2021, 15 March). Mother charged with deepfake plot against daughter’s cheerleading rivals. https://www.theguardian.com/us...

[16] Syndicated News. (2019). Authenticity of viral sex videos yet to be ascertained – The Mole. https://www.mole.my/authentici...

[17] Malaysian cabinet minister denies links to sex video. (2019, 9 December). https://www.euronews.com/2019/...

[18] Jha, P. (2019, 6 August). Malaysia’s New Sex Scandal: Look Beyond the Politics. https://thediplomat.com/2019/0...

[19] FMT Reporters. (2019, 17 June). Digital forensics experts not convinced that gay sex videos are fake. https://www.freemalaysiatoday....

[20] Aliran. Why deepfakes are so dangerous. (2021, 10 June). https://aliran.com/newsletters...

[21] Toews, R. (2020, 26 May). Deepfakes Are Going To Wreak Havoc On Society. We Are Not Prepared. https://www.forbes.com/sites/r...

[22] Cook, E. (2019, 29 August). Deep fakes could have real consequences for Southeast Asia. https://www.lowyinstitute.org/...

[23] Welch, C. (2019, 7 October). Can government fight back against deepfakes? https://apolitical.co/en/solut...

[24] Harrison, L. (2021, 20 April). Deepfakes Are on the Rise — How Should Government Respond?. https://www.govtech.com/policy...

[25] Solutions. (2021). DuckDuckGoose. https://www.duckduckgoose.nl/s...

[26] Fox, G., Liu, W., Kim, H., Seidel, H. P., Elgharib, M., & Theobalt, C. (2020). VideoForensicsHQ: Detecting High-quality Manipulated Face Videos. https://arxiv.org/pdf/2005.103...

[27] F. Matern, C. Riess and M. Stamminger, "Exploiting Visual Artifacts to Expose Deepfakes and Face Manipulations," 2019 IEEE Winter Applications of Computer Vision Workshops (WACVW), 2019, pp. 83-92, doi: 10.1109/WACVW.2019.00020.

Comentários